LM-Studio本地人工智能 -0.3.39-2

想要在没有互联网的情况下运行 AI?LM Studio 是一款强大的本地 LLM 桌面应用。本文将详细介绍 LM Studio 的核心功能、系统硬件要求、安装步骤以及如何通过 GGUF 格式配置本地模型,助你轻松搭建私密且免费的私人 AI 工作站。

下载地址:

123网盘:https://www.123865.com/s/ekeA-IUX4

小飞机网盘:https://share.feijipan.com/s/lwWb7fYt

一、 什么是 LM Studio?

LM Studio 是一款专为桌面端设计的图形化应用程序,旨在让用户能够极其简单地在本地环境(Windows, macOS, Linux)中发现、下载并运行开源的大语言模型(LLMs)。

核心价值: 传统的 AI 服务往往依赖云端,存在隐私泄露风险和订阅费用。LM Studio 实现了“本地 AI 自由”,支持包括 DeepSeek、Qwen3、Gemma3 等在内的前沿模型,且完全免费、离线可用。

二、 为什么选择 LM Studio?

在众多的本地部署工具(如 Ollama, LocalAI)中,LM Studio 凭借以下关键功能脱颖而出:

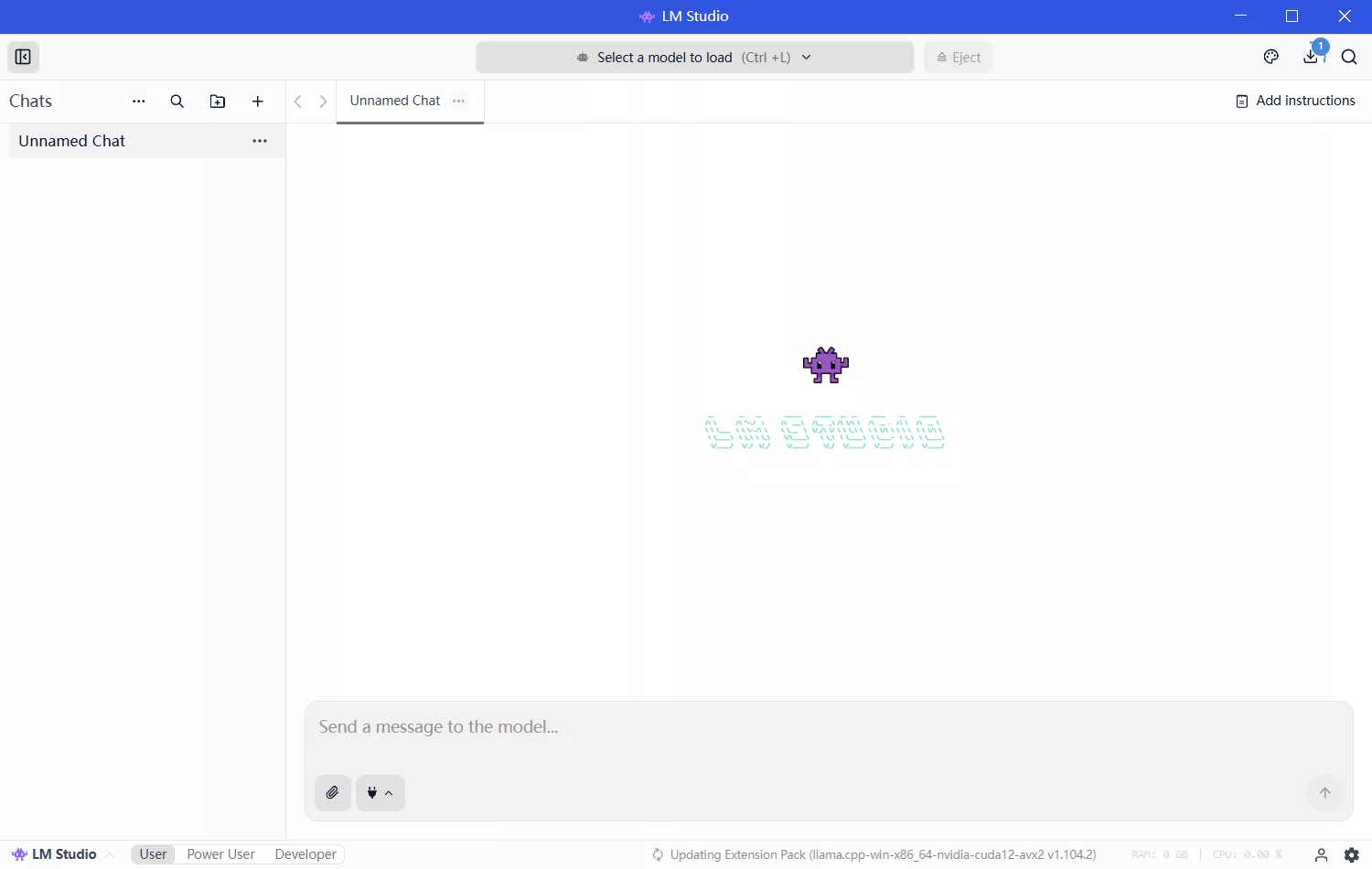

- 极简交互界面: 提供类似于 ChatGPT 的直观对话窗口,无需掌握复杂的命令行。

- 内置模型探索: 集成了 Hugging Face 搜索功能,可直接在应用内筛选和下载模型。

- 兼容 OpenAI 的本地服务器: 能够启动一个监听本地端点的服务器,使您的本地模型可以无缝接入任何支持 OpenAI API 协议的第三方工具。

- 跨平台支持: 完美适配 Apple Silicon (M1/M2/M3/M4) 以及高性能 Windows 和 Linux 设备。

- 开发者友好: 提供 Python 和 JS SDK,支持 MCP (Model Context Protocol) 客户端。

三、 硬件与系统要求:你的电脑能跑吗?

由于大语言模型对计算资源(尤其是内存和显存)有较高要求,请在安装前确认您的硬件配置:

1. macOS

- 芯片: 必须是 Apple Silicon (M1/M2/M3/M4)。注:目前不支持 Intel 芯片的 Mac。

- 系统: macOS 13.4 或更高版本(若需运行 MLX 模型,建议升级至 macOS 14.0+)。

- 内存: 推荐 16GB 或以上。8GB 用户建议选择 3B-7B 的小型量化模型。

2. Windows

- CPU: 必须支持 AVX2 指令集。

- 架构: 支持 x64 以及 ARM (Snapdragon X Elite)。

- 内存: 建议至少 16GB。若运行 14B 以上模型,显存 (VRAM) 大小将是决定运行速度的关键。

3. Linux

- 分发格式: 以 AppImage 形式提供。

- 系统: Ubuntu 20.04 或更高版本(暂不支持 aarch64)。